GPT4o上线首周,用户真实反馈大曝光

2025年,随着OpenAI重磅推出GPT-4o,AI圈内瞬间炸开了锅。作为ChatGPT的最新进化版,GPT-4o融合了语音、图像、情绪识别等多模态技术,被寄予厚望。然而,任何新技术的诞生都伴随着争议和挑战。

本文将大揭秘GPT-4o上线首周,来自全球用户的真实反馈,帮你客观了解这款AI神器的实力与不足。

一、用户点赞:功能强大,体验流畅

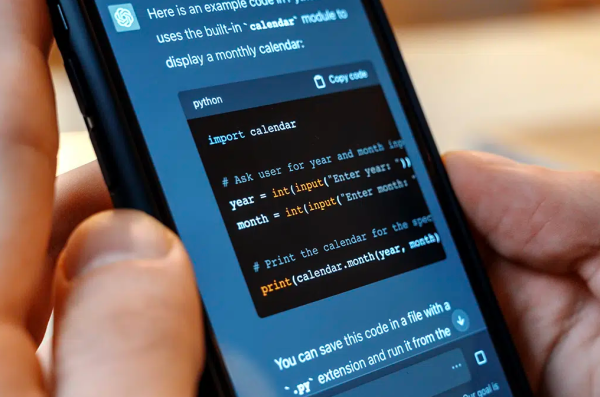

“GPT-4o太聪明了!”——不少用户在社交平台上称赞GPT-4o的多模态处理能力。支持语音聊天,让沟通更加自然;图像理解功能,可以直接上传图片问问题;还能感知用户情绪,回应更有人情味。

-

语音响应速度快,实时对话体验接近真人。

-

图像识别准确度高,尤其在文档辅助和创意设计场景表现亮眼。

-

情绪识别让用户觉得AI“更懂人”,聊天氛围更加轻松。

一位设计师用户说:

“用GPT-4o帮我看设计稿,给了不少实用建议,效率提升明显。”

二、吐槽声也不少:翻车、误判偶发

不过,用户反馈中也有不少“槽点”,主要集中在以下几个方面:

-

翻车现象偶有出现,特别是在复杂图像理解和多语言语音识别时,AI偶尔答非所问或理解偏差。

-

情绪识别功能尚不完美,对微妙情绪的感知能力仍有限,部分用户觉得反应“有点机械”。

-

使用门槛略高,部分新手用户不清楚如何切换到GPT-4o模型,导致体验不佳。

有网友调侃:

“GPT-4o有时候像是‘情绪小白’,还需要多多练习。”

三、专家解读:技术飞跃但仍需磨合

AI专家指出,GPT-4o代表了当前AI技术的顶尖水平,尤其是在多模态融合方面实现了突破。但任何新技术都需要经历一个“打磨期”:

-

多语言语音和图像识别的细节优化还在持续;

-

情绪识别需要更多样本和场景训练来提升准确度;

-

用户教育和界面优化对于提升整体体验至关重要。

四、用户建议与使用小贴士

根据用户反馈,以下几条使用建议能帮助你更好地驾驭GPT-4o:

-

确认模型版本:使用时确认已切换到GPT-4o模型。

-

明确输入:无论是语音还是图像,尽量提供清晰明确的信息。

-

合理期望:将GPT-4o视为高效助手,而非全能专家。

-

多模态混合输入:结合语音、文字、图片,获得更精准回答。

五、总结:GPT-4o正处于爆发前夜

从用户真实反馈来看,GPT-4o以其强大的多模态能力赢得了大量粉丝,也暴露了一些成长中的小问题。但无论如何,这一代AI已然拉开了“人人可用智能助手”的序幕。