GPT4o实测翻车?你可能没用对方式

GPT-4o横空出世,AI圈一片沸腾,但不少网友“实测”后却喊出一个字:“翻!”

语音聊天卡顿?图像识别不准?响应答非所问?

一时间,“GPT-4o翻车”成了热门搜索,吃瓜群众纷纷围观。

但真相也许并不像看起来那么“崩”。

你翻车,不一定是GPT-4o不行——可能只是你没用对方式。

别急着“卸载再见”,本文将用通俗又不失专业的方式,帮你解开GPT-4o“翻车”的真相。

一、GPT-4o到底更新了什么?

GPT-4o中的“o”代表 Omni(全能),这不是广告语,而是真·能文能语能看图:

-

💬 语音对话:能听会说,几百毫秒就能响应,像在跟真人通话。

-

🖼️ 图像理解:拍张图就能分析其中内容,甚至帮你读图写文案。

-

👀 情绪识别(测试中):能“感知”你的语气和情绪变化,回应也更贴近人类沟通逻辑。

听起来很强对吧?但强大的功能背后,也有操作门槛。

二、你“翻车”的五个常见原因

如果你在体验GPT-4o时感到“不如宣传”,可能中了以下“误区”:

1. ✅ 没选对模式

很多用户没注意,免费用户默认不一定用的是GPT-4o。需要在ChatGPT界面上手动切换模型,选择“GPT-4o”。

✅ 正确姿势:进入对话框 > 右上角模型名称 > 选择“GPT-4o”

2. ✅ 忽略了语言环境设置

GPT-4o对语音识别的语言环境较敏感,如果你用的是中文,但系统默认语言是英语,就容易出现听错、翻译怪异等问题。

✅ 正确姿势:确保语言设置与你使用的语种一致。

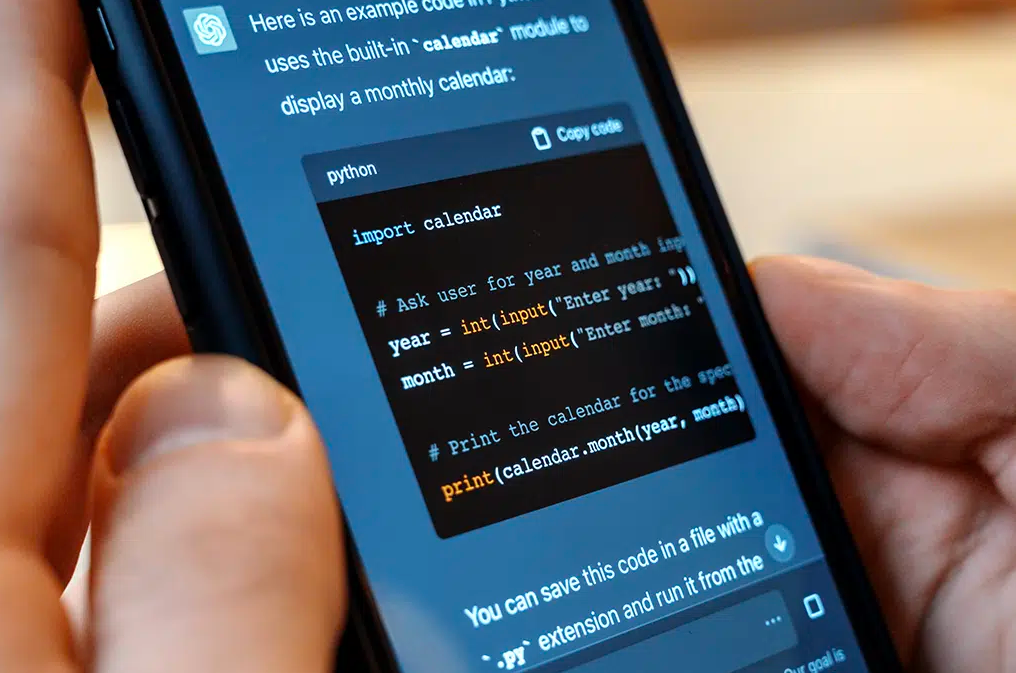

3. ✅ 图像识别用法不当

别指望发一张模糊截图就能得到“神分析”。GPT-4o虽强,但图像识别也需要高质量输入。

✅ 正确姿势:上传清晰图片,并明确提出问题(例如:“这张图里哪种食物更健康?”)

4. ✅ 语音输入方式错乱

有人尝试一边说话一边打字,还用方言夹杂英语,这种“语言混战”对AI简直是梦魇。

✅ 正确姿势:用一种语言说完一句话,尽量简洁清晰,语气自然。

5. ✅ 期望值过高

有人期望GPT-4o“秒懂情绪、分析心理、提出人生建议”,这有点儿强人所难了。

GPT-4o是AI,不是心理医生,也不是你爸妈。

三、掌握这三招,体验直接拉满

✨ 1. 多模态组合拳:语音+图像+文字一起上

别只靠一个输入方式。你可以说话的同时上传图像,再补充一句文字说明,GPT-4o的理解力会更强。

✨ 2. 引导式提问,别让AI猜你的心思

AI不是读心术大师,别问“你觉得这个怎么样?”——应该问:“你觉得这个设计在用户体验方面有哪些不足?”

✨ 3. 当AI是助手,不是“答案之神”

用GPT-4o来辅助,而不是全权依赖。比如写文章时让它提大纲、润色句子,而不是“你给我整个爆款出来”。

四、实测翻车≠产品失败,而是学习机会

在GPT-4o发布初期,OpenAI已明确指出:部分功能仍在优化中,尤其是语音和图像的多语言场景。

所以你遇到问题,不代表你“踩坑”,可能只是AI正在不断学习中。

而且,很多用户“翻车”之后,调整使用方法后发现:

“哇,居然真的像和真人对话一样!”

“图像识别简直就是我PPT排版的救星。”

“这AI不仅能说会写,还能安慰我失恋。”

五、结语:别着急下定论,GPT-4o才刚刚开始

“实测翻车”也许是你走近AI的一次重要体验,

但比翻车更重要的,是你是否学会了开对这辆车。

GPT-4o作为当前最先进的AI之一,正在重新定义人机交互的方式。与其抱怨不如多试试不同用法——你会发现,原来“未来感”就在手边。