在公司用ChatGPT合规吗?2025年6月企业数据风险提示

随着 ChatGPT 功能日益强大,越来越多公司开始尝试让员工在日常办公中使用 AI 工具:

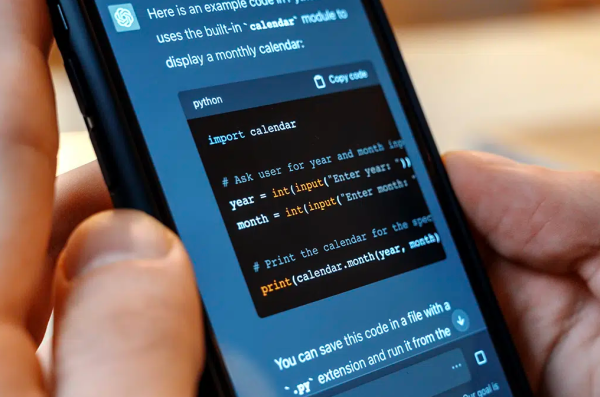

“让GPT帮忙写文案、润色PPT、分析Excel报表。”

“生成营销方案、草拟合规文书、做代码改写。”

“上传PDF,快速提炼会议纪要。”

这一切确实提升了效率。但与此同时,**“公司是否允许?”“上传内容是否泄密?”“这在法律上合规吗?”**也成为众多企业最关心的问题。

本文从 2025 年6月的视角出发,帮你全面识别在企业使用 ChatGPT 的数据风险,并给出合规建议与防护对策。

✅ 一、使用ChatGPT办公,企业真的允许吗?

企业是否允许员工使用 ChatGPT,主要取决于两类管理因素:

- 信息安全政策

- 很多公司已明文规定:禁止使用AI工具处理未经脱敏的内部信息

- 尤其在金融、医疗、教育、法律、互联网等数据敏感行业

- 合规与外部监管

- 若所在国家/行业受《GDPR》《CCPA》《网络安全法》等法规约束,未经用户同意或未设明处理机制,即使用AI生成内容或上传数据可能违反法律

📌 结论:是否合规 ≠ 是否好用,取决于公司内部政策 + 使用方式是否合规。

🧩 二、企业用ChatGPT的主要风险在哪里?

| 风险类型 | 典型情境 | 后果风险 |

|---|---|---|

| ❌ 数据外泄风险 | 员工上传合同、客户资料、财报等 | 可能导致商业机密被泄漏 |

| ❌ 模型训练风险 | 未关闭训练权限,导致上传内容参与训练 | 内容被AI“记住”,未来泄露可能性 |

| ❌ 责任归属风险 | 用AI生成合同、报价、技术文档 | 内容错误或违规,公司承担责任 |

| ❌ 越权使用风险 | 使用个人账号处理公司级数据 | 缺乏日志审计与权限控制 |

🔒 三、OpenAI在数据处理方面如何保障隐私?

截至2025年6月,ChatGPT 对用户数据的处理政策如下:

- 上传的内容默认不会用于模型训练(若关闭数据贡献选项)

- ChatGPT Team 和 Enterprise 版本提供更强的数据隔离、权限控制与日志审计功能

- 企业版支持部署在专属环境中,避免数据流出公共服务器

✅ 普通用户:关闭“允许用于训练”的设置后,数据仅限当前会话使用

✅ 企业/团队用户:可获得 OpenAI 提供的合规说明、审计报告与数据主权支持

🛡️ 四、企业使用ChatGPT的合规建议与最佳实践

✅ 对员工使用的控制建议:

| 项目 | 建议 |

|---|---|

| 使用版本 | 使用 ChatGPT Team 或 Enterprise 而非免费/Plus 个人版 |

| 上传内容要求 | 禁止上传未经脱敏的敏感信息 |

| 账号使用规范 | 禁止使用个人账号处理公司业务内容 |

| 员工培训 | 普及 AI 使用边界、合规常识、安全意识 |

| 日志审计与权限划分 | 企业账号应设立管理员,划分插件/文件等权限控制 |

🧠 五、这些行为建议企业强烈规避

- ❌ 用免费版 GPT 分析含客户身份信息的文件

- ❌ 让 AI “生成合同”后直接发送客户

- ❌ 多人共享一个账号、无法追踪责任

- ❌ 未关闭“数据贡献”选项,默认内容可能被学习

- ❌ 用插件联网分析公司网站或私有数据,未经审查

✅ 六、总结:AI可以提升效率,但不能突破合规底线

ChatGPT 是强大的工具,但对企业来说,它同时也是潜在的数据出口与合规盲区。

只要你:

- 明确哪些数据可处理、哪些不能上传

- 使用公司认证版本,关闭训练权限

- 在合规、安全、数据主权三方面做好准备

就能在不违规的前提下高效用好 AI 帮手。

在效率与责任之间,聪明的企业选择“合规优先”。