GPT-4O为什么被称为“通感AI”?原理大揭秘

什么是“通感AI”?

“通感”,这个词听起来有点玄乎。简单来说,“通感AI”就是能够同时理解和处理多种感官信息的人工智能。比如它不仅能“看”,还能“听”,还能“说”,还会“思考”,就像我们人类用眼睛、耳朵和大脑一起工作一样。

而 GPT-4o,就是 OpenAI 旗下的最新“通感AI”代表,被称为“通感AI”的典范。

GPT-4o的“通感”体现在哪里?

GPT-4o 不仅仅是文字聊天机器人,它结合了以下能力:

-

视觉感知:能识别图片中的物体、文字、场景;

-

听觉感知:支持语音输入,听懂你的话;

-

语言理解与生成:用自然语言和你交流,回答问题,生成内容;

-

多模态融合:将图像、声音、文字等信息统一处理,做到“多感官同步”理解。

通俗点说,GPT-4o就像拥有了“眼睛”和“耳朵”的人工智能。

为什么这很难做到?

把多种感官数据融合到一个 AI 模型中,技术上极其复杂,主要难点有:

-

数据形式差异大

图片是像素,语音是声波,文字是符号,怎么让一个模型同时理解这些不同“语言”? -

多模态信息如何统一处理?

传统AI模型通常专注一种数据,比如图像识别模型只看图,语言模型只处理文字。GPT-4o通过统一架构,将多模态数据转成统一的表示,能在一个“大脑”中处理。 -

实时响应和推理挑战

语音和图像信息量大,处理复杂,想要做到“边听边看边想”,还要快得像人类对话一样顺畅,非常考验算力和算法优化。

GPT-4o的原理大揭秘

-

Transformer架构升级

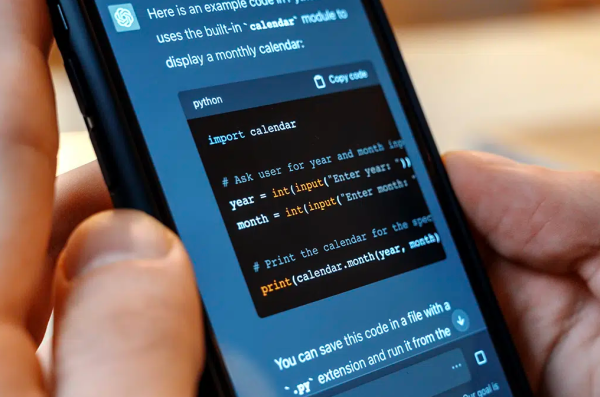

GPT-4o基于“Transformer”技术,但在结构上做了升级,支持将图像、声音和文字转成“tokens”(统一的小信息单位),让模型同时“读懂”这些不同模态。 -

多模态统一编码

语音和图像信息先被转换成特定的向量表示(embedding),然后与文字信息一起送进模型,实现信息融合。 -

大规模训练数据

GPT-4o训练时,使用了海量的多模态数据(图片+文字、语音+文字等),让它学会在不同感官间切换和关联。 -

优化推理速度

通过算法和硬件优化,实现了极低的延迟,保证实时对话体验。

为什么“通感AI”很重要?

-

它让 AI 能像人一样理解世界,更接近真实的智能;

-

适用场景更多:医疗影像分析、智能助理、多模态搜索、机器人交互等;

-

提升交互体验:你可以直接说话给 AI,给它看图片,获得更自然更精准的反馈。

结语

GPT-4o的“通感AI”让人工智能跨越了单一感官的限制,开启了真正多感官、多模态理解的新时代。未来,通感AI将融入我们生活的方方面面,成为贴心又聪明的数字伙伴。