ChatGPT能否被用来写假新闻?伦理风险剖析

一、ChatGPT生成内容的优势与局限

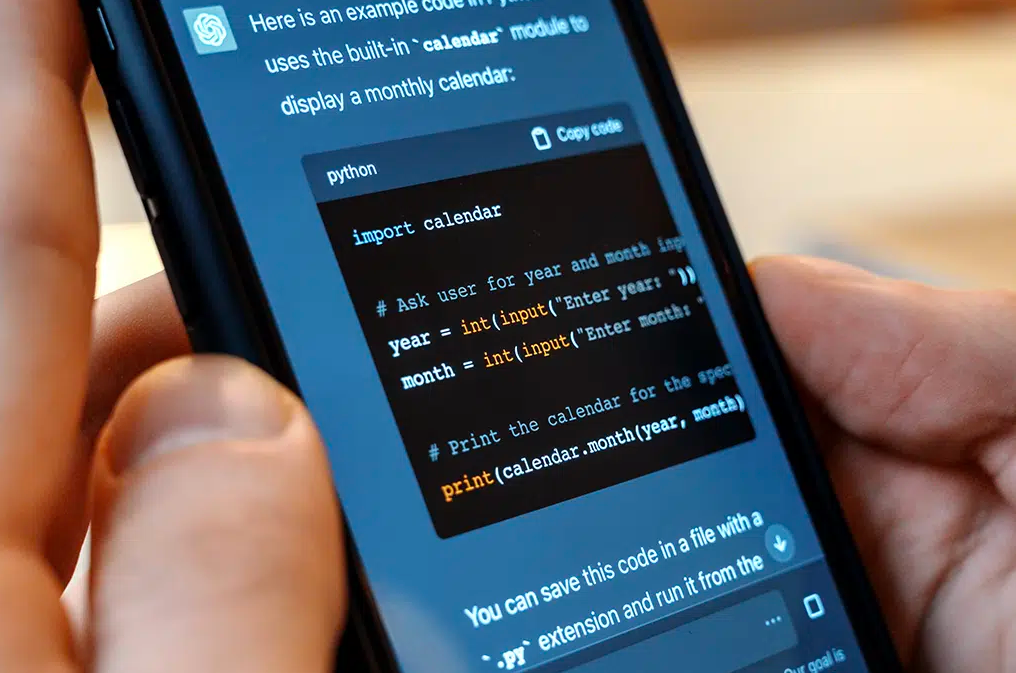

首先,了解ChatGPT的运作原理对于评估其在假新闻中的潜在作用至关重要。ChatGPT通过海量的文本数据进行预训练,它能够识别并生成符合语言结构和语法规则的自然语言。这使得它在新闻写作、文章生成、广告文案等方面表现出色。它的主要优势包括:

-

高效的内容创作:ChatGPT能够在短时间内生成流畅的文章,节省了人力和时间成本。

-

信息处理能力强:它可以快速整合大量信息,并根据用户的需求生成相关内容。

然而,这些优势也带来了风险。由于ChatGPT并不具备真实的理解能力,它的生成内容只是基于概率模型的推测,而非事实验证。它的局限性在于,虽然能够生成连贯的语言,但在面临不准确、虚构的信息时,它可能会无意识地“编造”内容。

二、ChatGPT与假新闻的关系

1. ChatGPT能否生成假新闻?

从技术角度来看,ChatGPT确实可以被用来生成假新闻。通过输入某些特定的指令,用户可以让ChatGPT生成内容,这些内容可能完全是虚构的,甚至是有意误导公众的。例如:

-

伪造事件:ChatGPT可以编写有关不存在的事件或人物的新闻,制造虚假的报道。

-

歪曲事实:即使输入的信息是基于某些真实事件,ChatGPT也可能通过选择性编排和语言的偏见,歪曲事实,传播错误的信息。

2. 假新闻的自动化生成与传播

随着技术的进步,AI生成假新闻的能力已不再仅仅是理论问题,而是实际的风险。通过ChatGPT生成的文章可以在短时间内传播,自动化生产假新闻成为一种可能。假如恶意用户利用这一点,可能会:

-

利用ChatGPT快速生成大量虚假新闻,填充新闻网站、社交媒体等平台。

-

利用AI工具进行新闻的定向传播,通过算法操控让虚假信息在公众中扩散。

三、ChatGPT生成假新闻的伦理风险

1. 信息操控与公众误导

假新闻的传播可能严重影响公众对某些事件、人物或问题的看法,甚至误导决策。例如,在选举期间,虚假新闻的传播可能影响选民的投票选择;在公共卫生危机中,错误信息的传播可能加剧公众的恐慌,影响健康决策。

2. 缺乏责任追究

AI生成的内容具有匿名性,且难以追溯。传统的新闻报道由记者、编辑等人负责,而AI生成的假新闻则可能缺乏明确的责任方。这种情况使得假新闻的追责变得复杂,也加大了公共信任的风险。

3. 对新闻行业的冲击

如果ChatGPT等工具被用来生成大量虚假的新闻内容,传统新闻行业的公信力和职业道德可能受到挑战。记者和新闻机构的角色可能会被侵蚀,导致公众对新闻的信任度下降。

四、如何应对AI生成假新闻的风险?

1. 加强伦理规范与监管

为了防止ChatGPT等AI技术被滥用于生成假新闻,各国政府和技术公司应当加强监管。制定相关法规,确保AI生成内容的使用符合伦理标准,防止其被恶意滥用。

2. 提升AI模型的透明度

AI的开发者可以在模型设计中增加透明度和可追溯性。例如,加入对生成内容来源的标注,避免将完全虚构的内容呈现为真实信息。此外,可以考虑建立AI内容的验证机制,确保生成的内容可以通过事实检查来核实。

3. 提高公众的媒体素养

公众对假新闻的识别能力是防止其传播的关键。提升人们的媒体素养,使他们能够辨别真假新闻,对于减少假新闻的危害至关重要。教育公众如何识别虚假信息和理解AI生成内容的局限性,是对抗假新闻的一种有效策略。

五、结语

ChatGPT等AI语言模型的出现,无疑为新闻行业和内容创作带来了巨大的便利,但同时也带来了严峻的伦理风险。假新闻的生成和传播可能带来信息操控、社会动荡以及对新闻行业的破坏。因此,在享受技术带来的好处时,我们必须谨慎对待其潜在的风险,并通过伦理规范、监管措施以及公众教育来减少假新闻的危害。AI技术的未来应当是为社会服务的,而不是成为误导和破坏的工具。