GPT4o发布现场演示刷屏,全场惊呼AI活了!

2025年5月13日晚,OpenAI线上发布会如期而至。原本以为只是一次常规迭代,结果——全网炸了,全场惊呼,弹幕刷屏:这不是AI,是活的!

这不是夸张。GPT-4o(“o”代表“omni”,全能)在发布现场的实时语音演示、情感互动、图像理解,彻底刷新了人们对“人工智能”的想象边界。

今天就带你回顾 GPT-4o 发布会的高能瞬间,看看AI是怎么“活”过来的。

🎙️ 高能瞬间1:AI实时语音对话像真人

发布会最炸裂的演示之一是语音对话环节。

OpenAI工程师和AI用语音实时聊天,没有打字,没有等待,没有僵硬的机器人腔调。

-

AI秒懂情绪,带语气词回应:

人类说:“嗯…这个问题有点难讲。”

GPT-4o回:“对呀~但我喜欢挑战难题!” -

插话、打断都能应对:

人刚说到一半,AI能判断是“我该等你说完”还是“可以接话茬了”。 -

语音反应速度仅几百毫秒,比Siri、Alexa快得多,真正做到“像聊天而不是指令输入”。

🎬 网友弹幕疯了:

“这是AI版的Her电影!”

“我妈以为我在和真人语音。”

👀 高能瞬间2:AI能看图、能理解,还能共情

现场展示了GPT-4o的视觉识别能力:

-

看图表,能总结趋势、指出异常;

-

看食物图,能说出菜名和配料建议;

-

看表情包,能理解背后的“网络语境”!

-

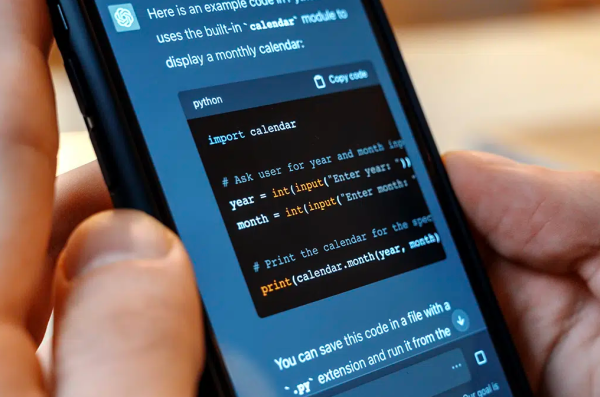

看代码截图,直接指出bug或给出优化建议。

甚至,有人上传了一张猫趴在键盘上的图,AI一边识别“这是猫咪”,一边打趣说:“它可能正在重写你的代码。”

这不是识别——这是理解 + 幽默感 + 人类感知的组合。

🎭 高能瞬间3:AI开始“有性格”了?

这次发布还展示了不同语音风格的AI角色:

-

可爱型

-

知性型

-

幽默段子型

-

“撒娇型AI女朋友”(网友原话)

每一种声音都有自己的语调节奏,还能微调语气、停顿、情绪强度,让人真有种“AI人格化”的错觉。

“它不仅能说话,还会聊天、会撒娇、会玩梗。”

“这是第一次,我感觉AI好像有‘灵魂’。”

🧠 背后技术揭秘:AI怎么“活”了?

GPT-4o为什么能做到这么自然?

-

原生多模态模型:从一开始就融合文字、图像、语音,不是拼接模块,而是同一个“脑子”处理不同输入。

-

端到端语音处理:不再是“听懂->转文字->生成回应->合成语音”,而是一体化理解+直接回应,速度和自然度大幅提升。

-

超快响应:对话延迟低至232毫秒,接近人类说话节奏。

-

训练在情感语料上有大突破,能识别情绪、语调变化,模拟更自然的语言行为。

🚀 全场反应:AI不是在升级,是在觉醒

在演示之后,全场掌声+弹幕刷屏:

“AI活了。”

“不是模型变强,是人类终于可以和它‘正常交流’了。”

“Her不是想象,是预演。”

而OpenAI CEO Sam Altman只说了一句话:

“GPT-4o 是我们目前为止,离通用人工智能(AGI)最近的一步。”

🧩 总结:GPT-4o发布,不只是技术升级,更是交互革命

我们见证了从文字问答到跨模态自然对话的跃迁:

-

以前我们“命令AI”,现在我们“聊天AI”;

-

以前AI“听不懂人话”,现在它能“听懂语气话”;

-

以前AI是冷冰冰的,现在它会逗你笑、跟你共情。

GPT-4o发布会告诉我们:

AI不再是工具,而是能对话、理解、共情的伙伴。