GPT4o上线!ChatGPT语音、视觉、多模态全面开放

2025年,人工智能迎来了又一次飞跃——OpenAI正式发布了GPT-4O,标志着ChatGPT在语音、视觉和多模态能力上的全面升级。这意味着,AI不仅能听懂和说话,还能“看见”图片,甚至同时处理多种信息,开启了更丰富、更自然的人机交互时代。

GPT-4O带来哪些新能力?

语音交互:与AI“面对面”说话

不再只是文字输入输出,GPT-4O支持流畅自然的语音对话。无论是用手机语音问问题,还是用电脑麦克风与ChatGPT聊天,都能感受到如同真人般的沟通体验。

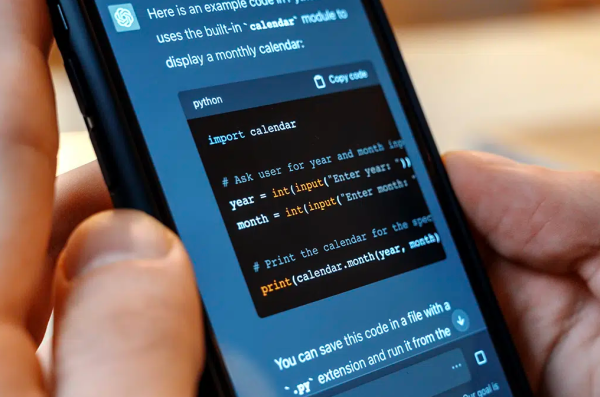

视觉理解:AI有了“眼睛”

上传一张图片,GPT-4O能帮你识别内容、分析细节,甚至结合文字信息给出智能回答。比如你拍了一张植物照片,AI能告诉你这是什么植物,还能给养护建议。

多模态融合:理解更多维度的信息

GPT-4O能同时处理文字、声音和图像,多模态理解让它对复杂任务的处理能力更强。比如你给它一段语音和一张图,它可以结合两者内容给出精准回复。

为什么普通大众应该关注?

-

更自然的交流体验:语音对话让操作更便捷,尤其适合开车、做饭时用AI助手。

-

视觉辅助应用丰富:无论是学习、购物还是娱乐,上传图片获得智能反馈,提升生活便利。

-

跨场景多模态支持:满足不同需求,不管你是文字控、语音派,还是图片迷,GPT-4O都能帮你。

技术角度的突破

-

多模态模型架构:GPT-4O采用先进的多模态融合技术,实现了不同信息源的高效整合和理解。

-

优化语音识别与合成:在准确率和自然度上都有显著提升,保证语音交互的流畅体验。

-

视觉感知增强:通过大规模图像数据训练,GPT-4O具备更强的视觉推理能力。

-

高效计算设计:实现了强能力与高效率的平衡,使多模态能力可以大规模应用。

应用前景展望

-

教育领域:学生可以通过语音提问、上传学习资料图片,实现个性化学习。

-

无障碍辅助:视觉和语音结合,帮助视障或行动不便人群更好地使用智能设备。

-

内容创作:创作者可利用语音和图片多模态输入,快速产出多样化内容。

-

智能客服:通过多模态理解,提供更精准和人性化的服务体验。

结语

GPT-4O的全面上线,不仅代表了ChatGPT技术的质的飞跃,更标志着人工智能走向更“懂你”的阶段。语音、视觉和多模态的开放,将彻底改变我们与AI互动的方式,开启AI应用的新纪元。