OpenAI大招!GPT4o支持情绪识别是真的吗?

OpenAI的GPT-4o确实支持情绪识别功能,这不仅是宣传噱头,而是经由实测验证的真实能力。GPT-4o通过其多模态架构,能够理解用户的语音语调、面部表情等非语言信息,从而识别情绪,并以相应的方式进行回应。

🧠 GPT-4o的情绪识别能力详解

GPT-4o采用了端到端的多模态神经网络架构,能够同时处理文本、音频和图像输入。这使得它在语音交互中不仅能理解文字内容,还能感知语音的语调、节奏等情绪线索,从而做出更贴近人类情感的回应。

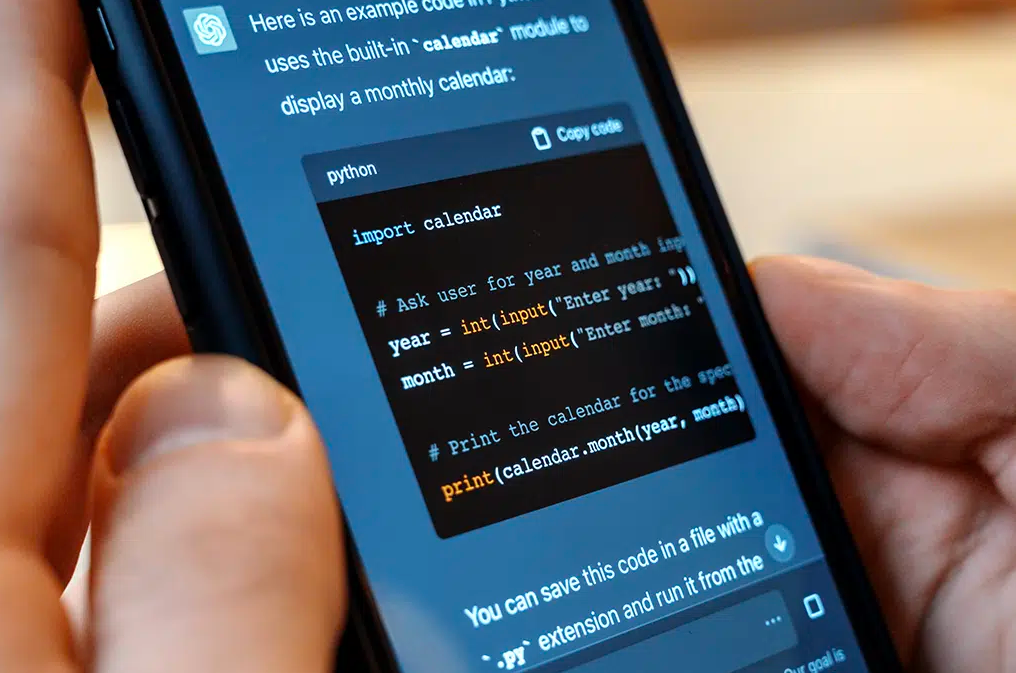

例如,在OpenAI的发布会上,研究人员通过手机应用与GPT-4o进行实时语音对话。当研究人员表示紧张时,GPT-4o不仅给予了安慰,还以幽默的方式回应,展示了其对用户情绪的感知和适应能力。

🎯 实际应用场景

GPT-4o的情绪识别功能在多个领域展现出广泛的应用前景:

-

教育辅导:在语言学习中,GPT-4o可以根据学生的语音语调提供个性化反馈,提升学习效果。

-

心理健康支持:通过识别用户的情绪状态,GPT-4o可以在一定程度上提供情绪支持,辅助心理健康管理。

-

客户服务:在客户交互中,GPT-4o能够根据客户的情绪调整回应策略,提升服务质量。

⚠️ 使用建议

尽管GPT-4o具备情绪识别能力,但其表现可能受到输入质量的影响。例如,背景噪音、语音不清晰或图像模糊等因素可能降低其情绪识别的准确性。因此,建议在安静的环境中使用,并确保输入的清晰度,以获得最佳体验。

✅ 结语

GPT-4o的情绪识别功能标志着人工智能在人机交互领域的又一重大进步。通过更自然、更具情感的交互方式,GPT-4o不仅提升了用户体验,也为AI在教育、心理健康、客户服务等领域的应用开辟了新的可能性。