大语言模型和ChatGPT的关系是什么?一文搞清楚AI底层逻辑

ChatGPT火了以后,网上“AI术语”也开始飞天乱舞:

“大语言模型”、“神经网络”、“Transformer”、“GPT-4”……看得人一脸懵。

最常见的问题就是:

“ChatGPT不就是个聊天机器人吗?那大语言模型又是啥?”

别急,今天这篇,用小白也能懂的方式,一文讲清:ChatGPT和大语言模型到底是什么关系?它们的底层逻辑又是啥?

一、大语言模型是“发动机”,ChatGPT是“整台车”

我们可以用一个类比来理解这俩关系:

-

大语言模型(LLM,Large Language Model) 是“AI大脑”,它拥有语言理解与生成的能力。

-

ChatGPT 是基于这个大脑“搭建的应用”,就像是一辆开在你手机里的“智能车”。

简单说:大语言模型是核心技术,ChatGPT是具体产品。

就像:

-

GPT-4 是引擎

-

ChatGPT 是“装了GPT-4的宝马”

-

你每天和ChatGPT聊天,其实是在“和一台封装好的GPT模型互动”

二、大语言模型到底是啥?为什么那么“大”?

“大语言模型”不是吹牛,它真的很大!它的“大”体现在三方面:

✅ 1. 数据量大

它吃下了海量数据:书籍、网页、论文、代码、新闻、百科……你能找到的文字,它大概率都见过。

✅ 2. 参数量大

像GPT-3有1750亿个参数,GPT-4更是“保密版本”,据传接近万亿级别。这些参数就是它“学会语言”的核心。

✅ 3. 运算量大

训练一个GPT模型可能需要几千块显卡同时运行几个月,耗电量堪比中型城市。

这就让它具备了强大的语言理解和生成能力,能写文案、答题、写代码、翻译、讲段子,甚至“模拟情绪”。

三、ChatGPT的“魔法”是怎么来的?

ChatGPT之所以这么好用,是因为在大语言模型的基础上做了很多优化,比如:

🧠 1. 微调(Fine-tuning)

先用公开数据训练模型,然后再用人类反馈(人类标注员打分)优化,让它更贴近人类需求。

🧠 2. 多轮对话能力

ChatGPT专门为“对话”场景优化过,可以记住上下文,理解提问背景,甚至“回顾你刚才说的话”。

🧠 3. 安全控制和内容过滤

它加入了大量规则和限制,防止输出敏感、不实、冒犯等内容。

所以你看到的ChatGPT,是一个**“有教养、讲人话、记得对话上下文”的大语言模型版本**。

四、其他产品是不是也基于大语言模型?

是的!现在很多AI应用其实都是“大语言模型的壳子”,例如:

| 产品名称 | 背后模型 | 应用特点 |

|---|---|---|

| ChatGPT | GPT-3.5 / GPT-4 | 通用写作、对话、办公助手 |

| Claude | Claude 3 | 长文本处理、逻辑推理出色 |

| Gemini(前Bard) | Gemini 1.5 | 搜索类任务更强,集成谷歌生态 |

| 文心一言 | 文心大模型 | 百度系,中文处理优先 |

| 通义千问 | 通义大模型 | 阿里出品,侧重多模态能力 |

这些产品都站在大语言模型的肩膀上,只是使用体验和功能设计各有千秋。

五、那未来呢?大语言模型=AI的“新基础设施”

大语言模型不只是能聊天,它正快速“入侵”各种行业:

-

医疗:辅助诊断、写病历

-

法律:生成合同、理解案例

-

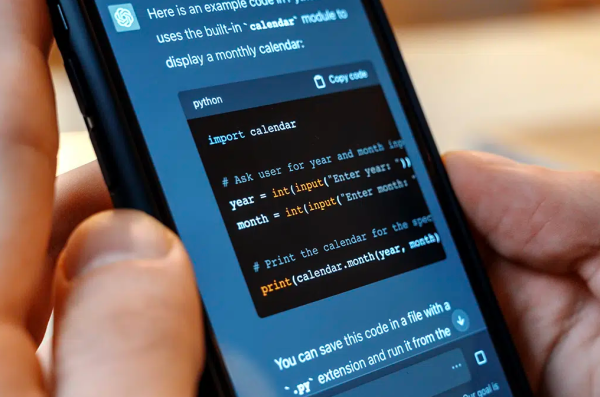

编程:自动补全、代码审查

-

教育:个性化辅导、内容生成

-

写作、客服、翻译……无处不在!

简单说,谁掌握大语言模型,谁就有了“AI时代的超级引擎”。

六、结语:ChatGPT是大语言模型的“亲民面孔”

你看到的“ChatGPT”,只是一种交互形式;它背后是日夜运转、吞吐万亿数据的庞然大物——大语言模型。

想搞懂AI?从大语言模型开始,搞懂了它,你就能理解整个AI世界的底层逻辑。