GPT-4O发布背后的OpenAI“秘密武器”曝光

GPT-4O的发布掀起了全球AI圈的狂潮。它不仅“能说、会看、懂你”,而且响应迅速、语音自然、识图准确,直接让Siri、Alexa看起来像“上个时代的产品”。但这场技术奇袭背后,OpenAI究竟动用了什么“秘密武器”?今天我们就来揭开这场AI革命背后的关键技术与战略部署。

秘密武器一:原生多模态模型

GPT-4O最大的不同,不在于“会说话”,而在于——它从一开始就是多模态的。

也就是说,它不是在语言模型上“外挂”视觉和语音模块,而是把文字、语音、图像都当作“第一语言”,一起训练。

这让GPT-4O具备了原生理解声音、图像、文字的能力,响应更快,理解更深,而且能“跨模态”联想,比如你说:“看这张图,它像不像XX?”——GPT-4O真的能接得住!

🎯 这就是区别于传统语音助手的根本——不是拼装,是一体。

秘密武器二:端到端语音模型 + 情感识别

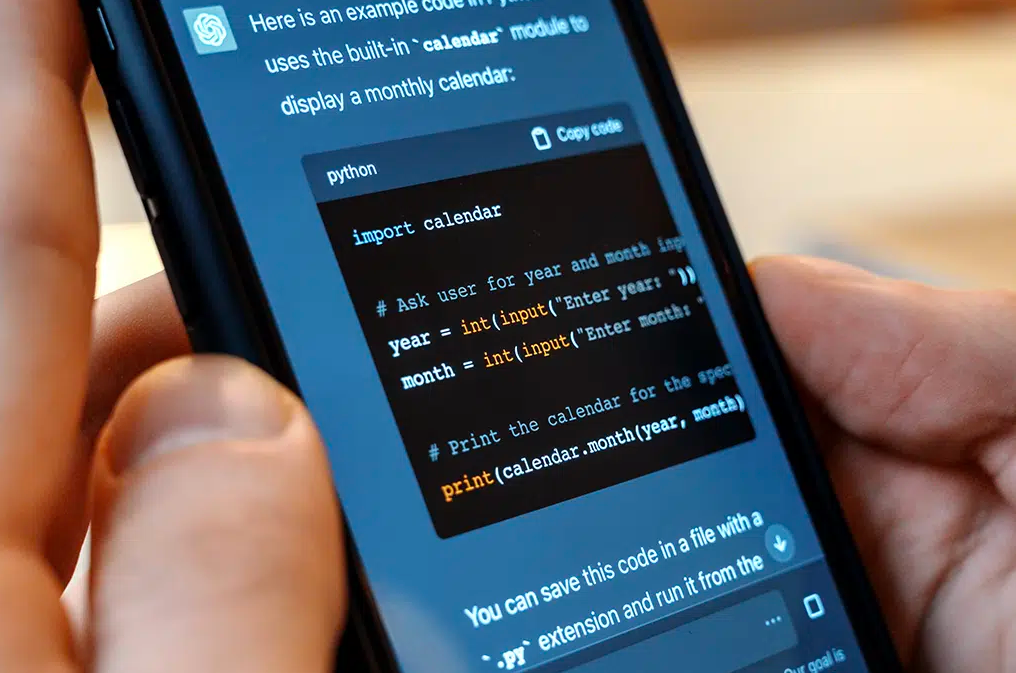

GPT-4O的语音对话,不是你说一句——转成文本——输入模型——再合成语音输出,而是直接从你的声音理解语义和情绪,直接输出语音回答,中间几乎无延迟。

而且,它能捕捉语气词、情绪波动,比如“嗯…”、“啊?”、“真的哦~”这样微妙的变化,反应速度接近人类对话水平。OpenAI官方演示的视频里,语音AI甚至能调情、讲段子、唱歌!

🎤 GPT-4O不是“能说话的ChatGPT”,而是“能听懂情绪的AI”。

秘密武器三:大规模优化的推理效率

我们常说AI模型越大越聪明,但“聪明”往往意味着“慢”。OpenAI这次的突破在于:GPT-4O不止强,还快,而且便宜。

据官方说法,它比GPT-4-Turbo 更便宜、更快、推理性能更高,这是通过架构优化、模型压缩和训练技巧实现的,核心策略包括:

-

混合专家机制(Mixture of Experts)

-

稀疏激活单元

-

训练-部署解耦设计

结果就是你可以在手机、网页甚至API上享受准实时AI语音对话,而不是等待一堆loading圈圈。

秘密武器四:OpenAI的产品战略 + 微软加持

别忘了,OpenAI不是单兵作战。GPT-4O一上线,就立刻集成到了:

-

ChatGPT免费版(终于升级)

-

语音对话功能(原来Plus版独享)

-

桌面客户端(新推出)

-

API接口(开发者福利)

再加上微软的大力支持(Copilot、Azure全系接入),GPT-4O不仅是技术升级,更是产品化、生态化、平台化的战略武器。

这是一场从“模型为王”到“体验为王”的转型,也预示着未来AI助手大战即将白热化。

总结:“不是叠buff,是换了核心引擎”

GPT-4O的强大不只是加入了语音、视觉等新技能,而是从根基上重新定义了“AI理解世界的方式”。而OpenAI在背后做出的技术革新、效率优化和产品整合,才是真正的“秘密武器”。

我们正在见证一个真正“听得懂、看得见、说得出、情绪在线”的AI走进现实——而这,很可能是通向通用人工智能(AGI)的一大步。