ChatGPT背后的技术逻辑,你了解多少?

它不是“聪明的人”,也不是“搜索引擎”,它是一个巨大的“语言预测系统”。

一、ChatGPT不是在“思考”,而是在“预测”

ChatGPT 属于 大型语言模型(Large Language Model, LLM),最核心的机制是:

预测下一个最合理的词是什么。

举个例子:

输入“今天阳光明媚,适合去……”,

ChatGPT 会通过上下文推测“公园”“海边”“散步”等词的概率,然后生成最合理的那一个。

它不是“知道”你要去哪里,而是“猜测”大多数人在这种句子里会说什么。

二、它是如何被“训练出来”的?

ChatGPT背后使用的是OpenAI的GPT系列模型(如GPT-3、GPT-4),其训练分三步:

1. 📚 预训练(Pre-training)

-

用互联网上海量公开文本(书籍、维基百科、代码、对话)训练模型

-

学习语言规律和“词与词之间”的统计关系

-

训练目标:预测句子中缺失的词(即语言建模)

2. 🧠 微调(Fine-tuning)

-

加入特定任务样本,如问答、摘要、对话风格等

-

教模型学会“怎么回答才像人”

3. 🤖 人类反馈强化学习(RLHF)

-

通过真实人类打分,强化“更有帮助、更安全”的回答方式

-

这是ChatGPT区别于早期GPT模型的关键:它更“像人说话”,更守规矩

三、ChatGPT的输入输出是怎么运作的?

你每次提问(Prompt),ChatGPT 会经历以下步骤:

-

文本转化为“Token”(词元)

-

比如“ChatGPT很好用” → 被切成若干token进行处理

-

-

通过Transformer架构处理这些Token

-

利用多层注意力机制(Self-Attention)理解词之间的关联

-

-

预测并输出下一组Token

-

一个一个“吐词”出来,形成完整回答

-

-

直到生成终止符号或达到限制长度为止

四、ChatGPT的核心技术关键词解析

| 技术名词 | 通俗解释 |

|---|---|

| Transformer | 模型架构,像是一种“阅读理解系统”,能看懂句子结构 |

| Tokenization | 把文本变成AI能处理的词元(不是按词切,是按字节编码) |

| Attention | 模型关注哪些词之间的关系(比如“它”指代谁) |

| RLHF | 人类打分+模型自学,让回答更“合理” |

| Prompt Engineering | 设计对AI说话的方式,让它更准确理解你的意图 |

五、ChatGPT和搜索引擎的本质区别

| 对比项 | 搜索引擎(如谷歌) | ChatGPT |

|---|---|---|

| 原理 | 查网页、关键词匹配 | 语言预测、生成文字 |

| 输出 | 链接/网页摘要 | 连贯文本 |

| 数据更新 | 实时联网 | 非联网(除非开启Browsing) |

| 灵活性 | 你找信息,它不加工 | 它整合信息、可以转化格式(如改写/列清单) |

六、ChatGPT的能力边界在哪里?

虽然它“像人”,但你要知道它的局限性:

❌ 它不会:

-

主动联网(除非使用Browsing或插件)

-

判断事实真伪,它只会“说出最可能的答案”

-

真正“理解”内容,它是预测器不是思想者

-

做任何自我意识、动机类行为(没有感情)

七、未来:语言模型向“智能体”进化?

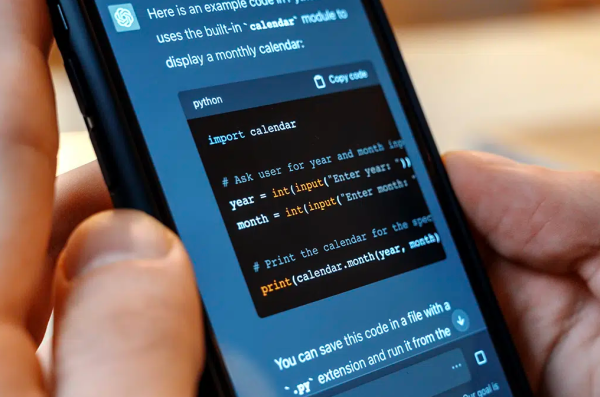

随着 ChatGPT 接入插件、浏览器、代码执行器、图像理解等模块,它的未来发展方向是:

从“生成语言” → 到“执行任务”

也就是说,它不只是能“告诉你怎么做”,还会帮你动手做:查资料、算账、写代码、生成图表、发送邮件……

这就是所谓的 AI Agent(智能体),可能是未来更高级形态的ChatGPT。

✅ 总结:ChatGPT背后的技术逻辑,核心三句话

-

它不是在思考,而是在预测下一个最合理的词

-

它通过海量文本训练+人类反馈微调,学会“像人说话”

-

它是一个生成系统,不是知识数据库或搜索引擎